Introduction: Les statistiques Q3 2025 de Backblaze confirment une légère hausse des pannes de disques durs, mais aussi l’excellente fiabilité des modèles récents de grande capacité, avec quelques “mauvais élèves” très clairement identifiés.

Chiffres clés du Q3 2025

Backblaze a suivi 328 348 disques de stockage sur la période du 1er juillet au 30 septembre 2025. Sur ce parc, 1 250 disques sont tombés en panne, pour un total de 29 431 703 “drive days” (jours de fonctionnement cumulés). Le taux de panne annualisé (AFR) atteint ainsi 1,55% ce trimestre, en hausse par rapport aux 1,36% du T2 2025, mais très proche du taux annuel 2024 de 1,57%.

Tendance générale des pannes

Cette hausse de l’AFR reste modérée et s’inscrit dans une tendance globale plutôt stable depuis plusieurs trimestres. Le taux de panne “lifetime” sur l’ensemble des données recueillies depuis 2013 reste d’ailleurs à 1,31%, inchangé ou presque par rapport aux trimestres précédents (1,30–1,31%). Pour les entreprises, cela signifie que les disques durs n’ont pas “brutalement lâché”, mais que certaines références tirent la statistique vers le haut.

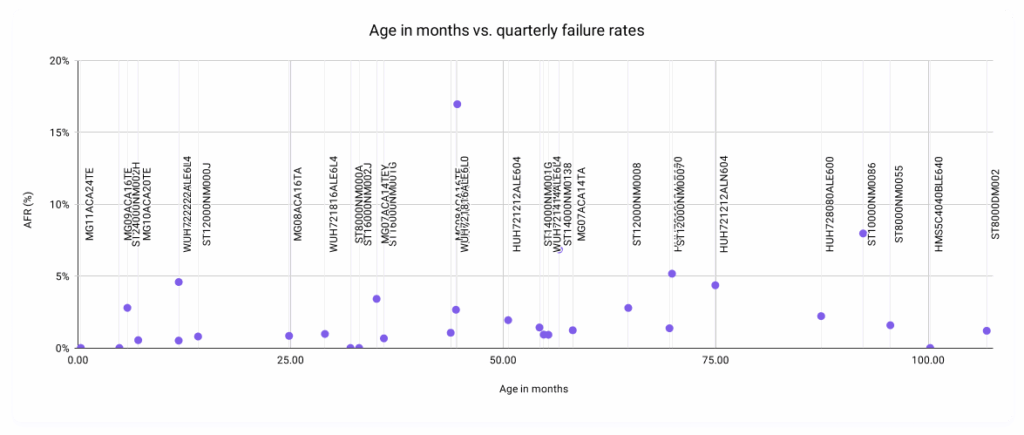

Ce que montrent les graphes Backblaze

Les graphiques Q3 2025 mettent en relation l’âge moyen des disques (en mois) et le taux de panne du trimestre, sous forme de nuage de points difficile à lire mais très instructif. Contrairement au schéma classique où l’on s’attend à voir les disques plus anciens massivement concentrés dans les taux de panne élevés, la majorité des points reste dans la zone de faible AFR, quel que soit l’âge. Ce pattern illustre deux choses : un pilotage actif de la flotte (surveillance SMART, retrait préventif des disques problématiques) et l’impact très fort de quelques modèles “hors norme” qui ressortent nettement dans le graphe.

Modèles 20 To et plus : un parc en expansion

Les disques de grande capacité (20 To et plus) prennent une place croissante dans le parc Backblaze. Parmi les modèles qui respectent les critères de l’analyse “lifetime” (plus de 500 disques et 100 000 jours de fonctionnement), Backblaze ajoute près de 7 936 unités supplémentaires en un trimestre. Au total, ces disques de 20 To et plus représentent 67 939 unités, soit environ 21% de la flotte, sans dérive inquiétante des taux de panne à ce stade.

Disques les moins fiables et les plus fiables du Q3 2025 (par rapport au taux de panne enregistré)

Le Q3 2025 voit un “club des zéro panne” particulièrement intéressant, avec quatre modèles qui n’enregistrent aucun échec sur le trimestre.

(voir les 4 premières lignes du tableau ci-dessous)

À l’autre extrême, trois modèles se distinguent par des taux de panne anormalement élevés au Q3 2025 (en prenant la méthode des quartiles de Tukey, seuil fixé à 5,88% d’AFR).

(voir les 3 dernières lignes du tableau ci-dessous)

| Modèle disque | Capacité | AFR Q3 2025 | Contexte clé |

|---|---|---|---|

| Seagate HMS5C4040BLE640 | 4 To | 0% | Disque ancien, mais extrêmement stable dans le temps. |

| Seagate ST8000NM000A | 8 To | 0% | Référence très fiable, quasi toujours dans le “zéro panne club”. |

| Toshiba MG09ACA16TE | 16 To | 0% | Disque d’entreprise récent, aucun incident au Q3 2025. |

| Toshiba MG11ACA24TE | 24 To | 0% | Nouveau 24 To, déjà éligible aux stats trimestrielles et sans panne. |

| Seagate ST10000NM0086 | 10 To | 7,97% | Disques très âgés, population limitée, ce qui gonfle l’AFR. |

| Seagate ST14000NM0138 | 14 To | 6,86% | Historique de pannes élevé sur plusieurs trimestres. |

| Toshiba MG08ACA16TEY | 16 To | 16,95% | Spike artificiel lié à une campagne de mise à jour firmware. |

Les modèles sans aucune panne

Ces modèles combinent un nombre significatif de disques en production et suffisamment de jours de fonctionnement pour que ce zéro panne soit réellement représentatif. À noter : le Seagate ST8000NM000A est régulièrement dans ce club, avec une seule panne recensée en Q3 2024, ce qui renforce sa réputation de “valeur sûre” pour le stockage.

Les “pires” taux de panne du trimestre

Backblaze explique que les deux modèles Seagate cumulent plusieurs facteurs aggravants : une ancienneté élevée (jusqu’à plus de 7 ans en moyenne) et un volume de disques relativement limité, ce qui amplifie l’impact de chaque panne sur le calcul de l’AFR. Pour le Toshiba MG08ACA16TEY, en revanche, le pic de 16,95% est lié à une opération de maintenance/firmware spécifique, qui a fait artificiellement apparaître des “pannes” dans les statistiques pour la période étudiée, sans refléter une réelle défaillance mécanique et représenterait alors une absence de pannes ou alors des pannes facilement « fixables » sur un plus long terme potentiel.

Comment Backblaze définit une “panne”

Un point fort de ce rapport Q3 2025 est la transparence sur la définition d’une défaillance, élément crucial pour interpréter les chiffres. Techniquement, Backblaze s’appuie sur les attributs SMART (via Smartmontools) et sur un outil de monitoring interne (“drive sentinel”) qui compte les erreurs de lecture/écriture non corrigées et les secteurs en attente de réallocation. Lorsque certains seuils sont dépassés ou qu’un disque disparaît durablement des rapports, il est considéré comme “failed”, information ensuite corrélée avec les tickets de maintenance (Jira) pour distinguer vraie panne, remplacement, clonage temporaire ou intervention planifiée.

Enjeux pour les entreprises et l’angle Recoveo

Pour une DSI, ces chiffres confirment qu’un taux de panne “normal” autour de 1–2% par an reste la règle, mais que quelques références peuvent devenir des points de fragilité majeurs si elles sont massivement déployées. La leçon clé : ne pas se limiter à la capacité ou au prix, mais suivre les retours de fiabilité par modèle, surveiller les SMART et anticiper les campagnes de remplacement quand des outliers apparaissent. Côté Recoveo, ces tendances rappellent l’importance de :

- Segmenter les parcs selon les modèles pour identifier les séries à risque.

- Mettre en place une surveillance proactive (SMART, logs, alertes) pour intervenir avant la panne critique.

- Prévoir des plans de sauvegarde et de reprise adaptés aux disques haute capacité, de plus en plus présents dans les infrastructures.

Sources: